Este artigo tem por

objetivo apresentar os conceitos relacionados à tecnologia touchscreen (tela de

toque) – suas características, histórico, padrões, melhores práticas, além da

sua contribuição ao desenvolvimento de novas soluções – como também introduzir

o leitor a uma API muito legível e de fácil integração chamada Gestures API a

partir da qual podemos explorar os benefícios proporcionados pelo touch à

plataforma Android. Em

que situação o tema útil: Uma vez que se faça

necessária a interpretação de eventos touchscreen descritos como um ou mais requisito(s)

em um projeto, este artigo poderá auxiliá-lo quanto à sua aplicabilidade

(análise) além de orientá-lo através de alguns exemplos práticos em modos de como

suportá-lo (implementação). Resumo DevMan À medida que

observamos as tecnologias em evidência (como ilustrado pelo Hype Cycle do

Gartner), o reconhecimento de gestos é uma das que estão em destaque e previstas

para grande adoção para os próximos anos. Logo, o acompanhar desta evolução e o

se capacitar em ferramentas afins são linhas de pesquisa que devem ser

consideradas como candidatas para a construção de diferenciais competitivos.

Portanto, este artigo vem para auxiliá-lo em seus primeiros passos.

TAP is the new click! Esta frase, de Dan Saffer, retrata uma realidade há anos aguardada, mas que nos últimos quatro anos tornou-se acessível e revolucionou o mercado de dispositivos móveis.

Com a introdução deste novo paradigma de interação, usabilidade e design – o touchscreen (tela de toque) – a concorrência pela inovação transformou o planejamento estratégico de inúmeras empresas, tanto dos grandes Players (fabricantes (OEM) e prestadores de serviços – já inseridos neste mercado) quanto de várias outras que observaram o real potencial de crescimento e de resultados – exigindo flexibilidade e agilidade para adaptação, investimento e então, participação.

Tais mudanças têm proporcionado aos consumidores e a nós (desenvolvedores) a possibilidade de usufruir de dispositivos, que a cada novo modelo/versão, disponibilizam um conjunto maior e mais capacitado de recursos e funcionalidades, além de prover a oportunidade de atuarmos em nichos do segmento nunca dantes praticados, em virtude da complexidade de suporte e implementação a eventos que ofereçam uma melhor experiência aos usuários e que possibilitam a construção de aplicativos mais ricos, interativos e dinâmicos.

Neste contexto, este artigo tem como proposta apresentar tal paradigma, seus conceitos, características e padrões, além de detalhar uma API Android específica para a manipulação de gestos, chamada Gestures, a partir da qual ilustraremos todas as suas facilidades para a construção de aplicativos que fazem do touch (toque), sua existência.

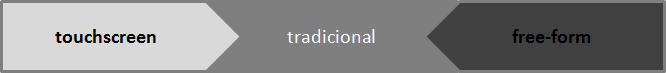

Características das interfaces

Ao compararmos os tipos de interface, podemos categorizá-los conforme a Figura 1. A maioria das funções disponíveis pelas interfaces tradicionais (como as providas pelos desktops) é suportada pelas gestures interfaces (interfaces de gestos) (tanto touchscreen quanto free-form). Estas são diferenciadas pelo modo como manipulam os objetos: touchscreen manipulam diretamente os objetos, permitindo aos usuários interagirem sobre a tela, enquanto free-form, não, ou seja, manipulam indiretamente (sem qualquer toque) geralmente, através de algum controle, luva ou por meio do nosso próprio corpo (veja a Nota DevMan 1).

Figura 1. Tipos de interfaces

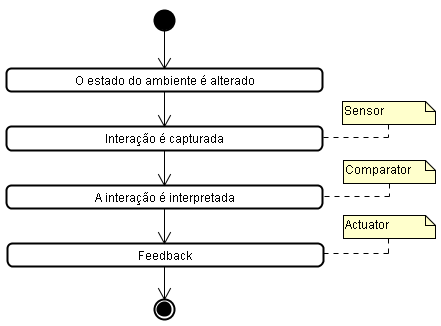

As gestures interfaces são constituídas basicamente pelos seguintes elementos: sensores (que detectam a interação), comparadores (que interpretam o evento) e os atuadores (que executam procedimentos em resposta ao evento interpretado), conforme ilustrado pela Figura 2.

Figura 2. Elementos constituintes das interfaces de gestos.

Há um grande conjunto de sensores suportados atualmente: Pressure (detectam quaisquer eventos relacionados a touch); Light (detectam luminosidade de um ambiente); Proximity (detectam proximidade de objetos); Acoustic (detectam sonoridade); Tilt (detectam inclinação); Motion (detectam movimento e velocidade) e Orientation (detectam posição e direção).

As plataformas de jogos são exemplos claros de free-form interfaces, como: PS3 Move, Microsoft 360 Kinect e Wii. Além destas, podemos citar outras que ao identificarem a presença de corpo ou sua movimentação executam algumas ações como: mover, ligar ou desligar – exemplos: controle de temperatura, alarmes, ducha e papel para secar as mãos.

Histórico das interfaces touchscreen

Com o intuito de reforçar a quantidade de estudos, pesquisas e análises já efetuados na indústria, universidades e centros de pesquisa para tornar viável e acessível ao mercado consumidor produtos embarcados com suporte a interações tanto touchscreen quanto free-form, vejamos na Tabela 1 um breve histórico da evolução desta tecnologia.

|

Ano |

Fabricante |

Descrição |

|

1977 |

Elographics |

Criou o primeiro device touchscreen, denominado Accutouch |

|

1982 |

Nimish Mehta |

Criou o primeiro sistema multitouch, denominado Flexible Machine Interface |

|

1983 |

Hewlett-Packard |

Foi a primeira empresa a incorporar uma interatividade de touchscreen (TAP) no PC, no HP 150 |

|

1990 |

Pierre Wellner |

Foi a primeira empresa a incorporar interfaces de gestos em uma mesa digital, denominada Digital Desk |

|

1994 |

IBM e Bell South |

Criou o primeiro celular touchscreen, denominado Simon |

|

2001 |

Lionhead Studios |

Foi a primeira empresa a incorporar interfaces de gestos em um jogo, denominado Black & White |

|

2006 |

Nintendo |

Primeira grande plataforma/console de jogos free-form, o Wii |

|

2007 |

Apple |

Revolucionou o mercado com o lançamento de dois novos conceitos: iPod Touch e iPhone |

|

2008 |

Microsoft |

Revolucionou também o mercado ao lançar um novo conceito em mesa digital, chamada MS Surface |

Tabela 1. Histórico de evolução das interfaces touchscreen e free-form.

Padrões de interatividade suportados pelas interfaces touchscreen

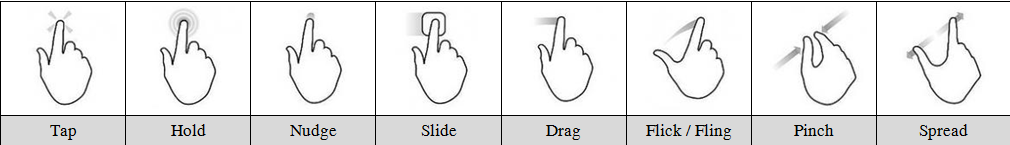

À medida que os dispositivos passaram a interpretar touch, um grupo seleto de movimentos e/ou gestos foi mapeado por tais interfaces e sistemas operacionais proporcionando interações mais ricas, práticas e de fácil aprendizado (veja a Nota DevMan 2). O conjunto de interações mapeadas e possíveis de serem realizadas é demonstrado na Figura 3.

Figura 3. Padrões de interatividade suportados pelas interfaces touchscreen.

E para quais ações devemos utilizar cada um destes padrões? Tap é comumente utilizado para pressionar botões, ativar, desativar e selecionar elementos da UI (user interface), semelhante ao click. Para ações em que há a necessidade de pressionar e segurar elementos como barras de rolagem para scrolling, podemos utilizar o Hold. Já o Nudge é usado para movimentarmos objetos/elementos da UI. Drag e Slide são padrões também utilizados para a movimentação de objetos permitindo inclusive atuarmos sobre barras de rolagem para posicionamento da UI (itens). Para o caso de desejarmos percorrer rapidamente uma lista de opções, o padrão a ser utilizado é o Flick ou Fling. E para ações de seleção e/ou redimensionamento (de escala) sobre elementos da UI, como aumento ou diminuição de ZOOM, temos respectivamente as opções, Spread e Pinch.

Com o objetivo de ilustrar o quão rápido e natural é o aprendizado e interação sobre as interfaces touchscreen, há dentre as referências/links do artigo um vídeo em que uma criança utiliza de um dos padrões mais simples (como o toque) para interagir com dois objetos e ao observar que em um deles há um feedback imediato para cada ação, um novo interesse ou preferência se destaca, proporcionando aprendizado. Tal comportamento foi muito bem observado pelos fabricantes e tal riqueza em usabilidade é hoje um dos motivos principais pelo enorme sucesso de aceitação e preferência do mercado consumidor, observado pelo crescente número de vendas de smartphones e tablets.