Data Mining: conceitos e casos de uso na área da saúde

Olá pessoal. Estamos de volta e nesta coluna vou conversar com vocês sobre duas coisas que eu acho muito interessante, Mineração de Dados e aplicações na área da saúde. Minha área é bioinformática, mas aqui vou mostrar alguns cases no uso clínico, muito interessante, vale a pena à leitura.

Bem para começar, data mining é a exploração e a análise, por meio automático ou semi-automático, de grandes quantidades de dados, a fim de descobrir padrões e regras significativas (Berry et al., 2000). Estes padrões e regras significativas são descritos muitas vezes como conhecimento invisível. São assim chamados por estarem envoltos em um grande volume de dados e que se não fossem usadas técnicas inteligentes para procurar esta informação, ou conhecimento, ele não seria descoberto facilmente pela observação humana. O conhecimento gerado pelo data mining pode ser usado para o gerenciamento de informação, processamento de pedidos de informação, tomada de decisão, controle de processos, entre outros. Para realizar essa coleta, o processo de Data Mining agrega em suas etapas conhecimento de áreas como a Inteligência Artificial e Estatística. Os métodos de Inteligência Artificial dão ao processo de mineração o status de processo inteligente. Técnicas como redes neurais, árvores de decisão, regras de associação, raciocínio baseado em casos e algoritmos genéticos são as mais usadas na construção deste processo. A estatística doa da sua parte diversas técnicas para agrupamento e análise de dados, uma das técnicas mais utilizadas em data mining é a regressão, termo e cálculos, herdados da estatística tradicional.

1 - Técnicas

Como descrito na introdução deste trabalho, existem diversas técnicas utilizadas dentro do processo de data mining. Para deixar mais claro como o processo trabalha com estas técnicas, vamos descrevê-las um pouco melhor.

Estas técnicas são utilizadas em diversas atividades (Gobel, et al.,1999) como:

- Previsão: Dado um determinado item e um respectivo modelo, é a capacidade de deduzir um valor para um atributo específico do item;

- Regressão: Dado um conjunto de itens, é a análise da dependência entre os valores de atributos e, automaticamente, produzir um modelo que possa prever valores de atributos para novos itens;

- Classificação: Dado um conjunto de classes pré-definidas, é determinar a qual destas classes um novo item pertence;

- Agrupamento: Dado um conjunto de itens, determina-se um conjunto de classes, nos quais os itens são agrupados de acordo com suas características;

- Associação: Dado um conjunto de itens, é a identificação dos relacionamentos existentes entre os atributos destes itens.

1.1 – Regras de Associação

As técnicas de regras de associação estabelecem uma correlação estatística entre certos itens de dados em um conjunto de dados (Gobel et, al., 1999).

A regra de associação pode ser representada por: X1^...^Xn => Y[C,S], onde X1, ..., Xn são itens que prevêem a ocorrência de Y com um grau de confiança C e com um suporte mínimo de S e ^ denota um operador de conjunção (AND).

Um exemplo desta regra pode ser que 90% dos consumidores de chocolate, também consomem pílulas de emagrecimento. O percentual de 90% é chamado de confiança da regra. O suporte da regra chocolate => pílulas de emagrecimento é o número de ocorrências deste conjunto de itens na mesma transação.

Alguns algoritmos que utilizam esta técnica são: Apriori, AprioriTid, entre outros.

1.2 – Árvores de Decisão

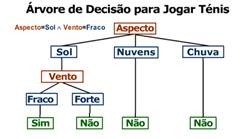

As árvores de decisão são representações gráficas onde os nós representam amostras e as folhas representam categorias.

Uma árvore de decisão designa uma classe numérica (ou saída) para uma entrada padrão filtrando-se a amostra através dos testes na árvore. Cada teste possui reciprocamente resultados exclusivos e exaustivos.

Quando a amostra de uma população está sendo estudada com o objetivo de se fazer alguma inferência indutiva, as árvores de decisão são os modelos mais utilizados.

Em muitos exemplos vemos árvores de decisão construídas usando sua idéia apenas com resultados booleanos, porém não estamos limitados a implementação destas funções.

Na figura 1 temos um exemplo de uma árvore de decisão para um jogo de tênis.

Figura 1

Alguns algoritmos conhecidos de árvore de decisão são: CART, CHAID, C5.0, ID3, entre outros.

1.3 – Raciocínio Baseado em Memória

O raciocínio baseado em memória combina as vantagens da recuperação da informação e do raciocínio baseado em regras.

O fato dos programadores utilizarem a experiência de problemas anteriores para resolverem muitos dos problemas novos, torna o raciocínio baseado em memória particularmente apropriado para sistemas de suporte.

Uma questão importante em raciocínio baseado em memória é a representação do caso (conhecimento) no computador. Em essência, os casos devem manter a informação necessitada pelos usuários. Kolodner (Kolodner, 1993) descreve casos como contendo três partes principais, que seriam:

1. A descrição do caso, a qual permite sua identificação e armazenamento;

2. O caso em si, contendo as informações relevantes para o domínio de sua aplicação;

3. O estado posterior do domínio quando a solução é aplicada.

Raciocínio baseado em memória é uma tecnologia emergente para a representação e processamento de conhecimento. Usa experiência passada, acumulando casos e tentando descobrir por analogia soluções para outros problemas.

Os principais algoritmos representantes dessa técnica são: BIRCH, CLARANS, CLIQUE e K-MEANS.

1.4 – Algoritmos Genéticos

Os algoritmos genéticos surgiram de uma metáfora com Teoria da Evolução das Espécies de Charles Darwin.

Os algoritmos genéticos incorporam uma solução potencial para um problema específico numa estrutura semelhante a de um cromossomo e aplicam operadores de seleção e cross-over a essas estruturas de forma a preservar informações críticas relativas à solução do problema.

O modelo matemático dos algoritmos genéticos ajuda a compreender melhor como ele trabalha.

Um exemplo de maximização da função f(x) = x2 pode ser útil para entendermos todo o processo.

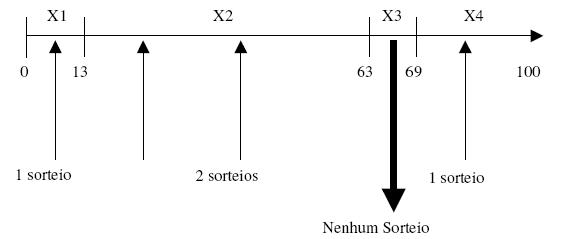

Vamos maximizar f(x) = x2 no intervalo de zero a trinta e um. Podemos iniciar a população de cromossomos com quatro escolhidos aleatoriamente.

x1 = 13, x2 = 24, x3 = 8, x4 = 19

Calculando a função de adaptação (no nosso exemplo o próprio f(x) = x2) para cada termo teremos:

f(x1) = 169, f(x2) = 576, f(x3) = 64, f(x4) = 361

Podemos ver que a melhor solução nesta geração é x2.

A adaptação geral é a soma de todas as adaptações de cada cromossomo, ou seja, 1170. Em percentuais temos x1 participando com 14%, x2 com 49%, x3 com 6% e x4 com 31%. Precisamos sortear quatro números aleatórios entre zero e cem e verificamos em que ponto da reta entre zero e cem esses números encontram-se e então fazemos a cópia dos cromossomos. De tal forma o cromossomo x1 será copiado uma única vez, o cromossomo x2 será reproduzido duas vezes, o cromossomo x3 não será reproduzido, pois nenhum sorteio aleatório caiu dentro da faixa de 6% entre 64% e 69% e o cromossomo x4 será reproduzido apenas uma vez.

Gráfico 1 – Algoritmo Genético

A nova geração após a reprodução será: x1 = 13, x2 = 24, x3 = 24 e x4 = 19.

Podemos notar que x2 é igual a x3 nesta nova geração e que x3 da geração anterior por ser pouco adaptado não se reproduziu, por isto não há nenhum representante seu nesta nova geração.

Essa nova geração representa a combinação das soluções bem-sucedidas da geração anterior que se casaram e se reproduziram.

É possível continuar o processo de evolução, mas ele pode ser interrompido se o valor for considerado suficiente ou até atingir o valor máximo da função f(x) no intervalo de zero a trinta e um.

1.5 – Redes Neurais

As redes neurais são uma classe especial de sistemas modelados seguindo analogia com o funcionamento do cérebro humano e são formadas de neurônios artificiais conectados de maneira similar aos neurônios do cérebro humano (Goebel et. al., 1999).

Um neurônio artificial é uma unidade de processamento lógica que tenta simular o comportamento e funções de um neurônio biológico. Nessa estrutura os dendritos do modelo biológico são substituídos pelas entradas de informação na unidade de processamento e as ligações entre o corpo celular são realizadas através de pesos, que simulam as sinapses.

As informações captadas na entrada são processadas pela função de soma (?) e o limite de disparo do neurônio biológico é substituído pela função de transferência.

Figura 2 – Modelo de Neurônio Artificial

A proposta de McCullok e Pitts, em 1943, para o trabalho de um neurônio pode ser resumida da seguinte forma:

1. Sinais são apresentações de entrada.

2. Cada sinal é multiplicado por um número, ou peso, que indica a sua influência na saída da unidade.

3. É feita a soma ponderada dos sinais que produz um nível de atividade.

4. Se o nível de atividade exceder um certo limite a unidade produz uma determinada resposta de saída.

Vamos exemplificar melhor.

Suponhamos que existam p sinais de entrada x1, x2,..., xn e pesos w1, w2, ..., wi e o limitador t. Os sinais do nosso exemplo serão de valores booleanos (0 e 1) e os pesos com valores reais.

No nosso caso, o nível de atividade a é dado por:

a = w1x1 + w2x2 + ... wixn

A saída y é dada por:

y = 1, se a >= t ou

y = 0, se a < t.

Boa parte dos modelos de redes neurais usados possui alguma regra de treinamento onde os pesos são ajustados de acordo com os padrões apresentados. De maneira simplória podemos dizer que as redes neurais aprendem através de exemplos.

Normalmente as redes neurais são apresentadas em forma de camadas, onde a primeira camada, chamada de entrada, recebe as primeiras informações que deverão ser processadas, a segunda camada é conhecida como camada intermediária ou camada oculta, ela pode ser formada por mais de uma camada de neurônios e nela são feitos os processamentos da rede. Por último a camada final, denominada saída é onde o resultado é apresentado.

A forma como essas camadas trabalham e como elas são interligadas definem a topologia de uma rede.

Algumas das principais topologias que encontramos hoje em dia são: Perceptron, Rede de Kohonem, Rede de Hopfield, Redes ART, Redes MLP, entre diversos outros.

2 – Exemplos de Aplicações na área da Saúde

Consolidando os conceitos apresentados anteriormente, apresentamos exemplos simples e inseridos dentro da área de saúde, sem a intenção de fazer uma lista exaustiva de casos, nem efetuar uma análise detalhada sobre cada exemplo apresentado. Com os exemplos apresentados, é demonstrado o poder das ferramentas de data mining e quanto as mesmas podem contribuir para melhorar a qualidade dos serviços de saúde.

Para facilitar a compreensão dos exemplos foi definida uma estrutura de apresentação constituída por contexto, metodologia, técnica utilizada, resultados e conclusão. Nenhum dos itens definidos expressa qualquer análise ou opinião pessoal dos autores deste artigo. O conteúdo referente a cada item mantém, com exatidão, a idéia expressa no artigo original.

No item destinado à descrição da técnica utilizada, será indicada, basicamente, a atividade do processo de data mining, de acordo com Gobel (Gobel et al., 1999). Não são analisados os detalhes computacionais apresentados no artigo original, pois a intenção é apenas mostrar a aplicabilidade de uma ferramenta de data mining.

2.1 – Exemplo 01: A process-mining framework for the detection of healthcare fraud and abuse.

Contexto:

Neste trabalho (Yang, 2006), desenvolvido por pesquisadores da Universidade Changhua de Taiwan, é proposto um processo de data mining, baseado no conceito de pathways (“Guide Lines”) para elaboração automática de modelos para detecção de casos abusivos ou fraudulentos nos sistemas de saúde (pena no Brasil não haver interesse nisso).

A motivação do trabalho vem da constatação do grande percentual de comportamentos abusivos e fraudulentos ocorridos nos sistemas de seguro saúde.

O objetivo principal é aplicar técnicas de data mining e, a partir de dados de casos clínicos, construir modelos a partir dos quais seja possível distinguir, automaticamente, comportamentos fraudulentos de atividades normais.

Metodologia:

Os dados utilizados para a avaliação do modelo foram a base do BNHI (Bureau of National Health Insurance) de Taiwan. Para este estudo, foram utilizados os dados referentes ao departamento de ginecologia, especificamente sobre PID (Pelvic inflammatory disease) que é a patologia mais comum neste departamento. Foram coletados dados de um hospital regional, provedor de serviços para o NHI. Inicialmente, foram selecionados dados de 2543 pacientes referentes ao período de 07/2001 a 06/2002 e a partir daí preparados dois conjuntos de dados: um contendo os casos normais e outro os fraudulentos. A preparação dos dados ocorreu através dos seguintes passos:

- Os dados iniciais foram filtrados para eliminar os registros com itens de dados sem valores ou com valores incoerentes. Neste processo foram eliminados 77 registros.

- Baseado nos registros restantes, as atividades médicas envolvidas do processo foram identificadas. Nesta etapa, foram identificadas 127 atividades médicas relacionadas ao processo de diagnóstico e tratamento de PID.

- A próxima etapa foi a identificação “manual” dos casos fraudulentos, no conjunto de dados selecionado. A identificação foi realizada por dois ginecologistas que examinaram todos os registros e identificaram 906 casos fraudulentos.

- Finalmente, os mesmos ginecologistas selecionaram 906 casos considerados normais para elaborar a base de teste contendo 1812 registros.

Técnicas Data Mining utilizadas:

O framework proposto envolve as técnicas de Regressão e Classificação.

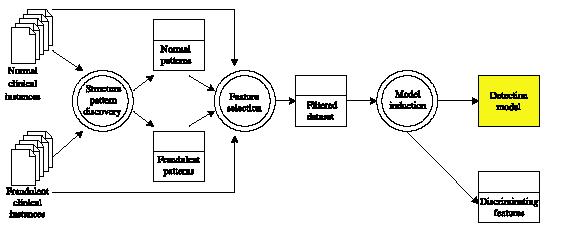

Inicialmente foi definido um fluxo geral que compreende todo o processo de data mining proposto, conforme a figura 3. Neste processo, dois conjuntos de exemplos clínicos servem como entrada; um normal e um fraudulento. A partir desta entrada, os padrões são extraídos e, consequentemente, os modelo são definidos. Há modelos que representam casos fraudulentos e modelos que correspondem a casos normais. Com os modelos de detecção elaborados, os registros das atividades podem ser submetidos para um mecanismo de indução que os classificarão como normais ou fraudulentos.

Figura 03 – Data mining framework

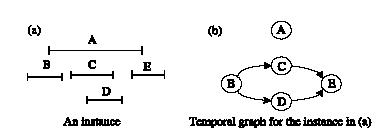

A técnica de data mining utilizada para a representação dos modelos é baseada em grafos que determinam as atividades envolvidas em um caso clínico e a respectiva seqüência temporal.

Figura 04 – Grafo para caso clínico

O algoritmo utilizado para indução (classificação de uma ocorrência como normal ou fraudulenta) foi o CBA (Classification Based on Associations).

Resultados:

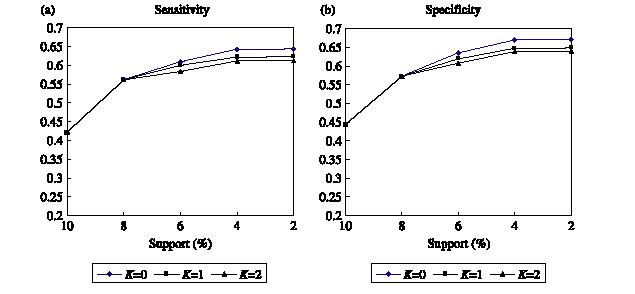

A avaliação dos resultados referentes a indução, foi baseada nas medidas de “Sensibilidade” e “Especificidade”, onde sensibilidade corresponde ao percentual de casos fraudulentos detectados, com base no total de casos fraudulentos existentes e especificidade equivale ao percentual de casos normais identificados diante do total de casos normais.

Os melhores resultados obtidos foram 64% e 67% para sensibilidade e especificidade, respectivamente. A figura 5 mostra a variação destes resultados, de acordo com ajustes efetuados no algoritmo de classificação.

Figura 05 – Sensibilidade e Especificidade.

Conclusão

Os autores concluíram que o framework desenvolvido auxiliou na descoberta das características que possuem alto poder discriminatório para representação de casos clínicos e o mostrou-se eficiente na identificação de alguns casos abusivos e fraudulentos que não seriam facilmente identificados manualmente.

2.2 – Exemplo 02: Data Mining approach to policy analysis in a healh insurance domain.

Este artigo (Chae, 2001) é bem rico no emprego de técnicas de data mining, pois são aplicados métodos para regressão, previsão e definição de regras de associação.

Contexto:

Desenvolvido por pesquisadores do Departamento de Ciência da Computação da Pohang University e Yonsei University, ambas da Coréia do Sul.

O objetivo do trabalho é a aplicação de técnicas de data mining na base de dados KMIC (Korea Medical Insurance Corporation) visando a descoberta de informações não triviais para auxílio no monitoramento do programa de controle de hipertensão.

Metodologia:

Para o desenvolvimento e conseqüente validação da aplicação de data mining, foram selecionados um subconjunto de dados do KMIC. Os registros foram selecionados aleatoriamente de uma população de 127.886 beneficiários. Inicialmente foram incluídos 100% dos beneficiários com hipertensão (9.103) e, posteriormente, foram selecionados, de forma aleatória, o mesmo número de registros para beneficiários sem hipertensão, totalizando 18.206 registros. Os registros continham dados biométricos, coletados durante o exame físico realizado bienalmente, como pressão, taxa de glicose, colesterol, altura, peso, etc. A hipertensão foi definida pelos valores da pressão sistólica > 140 mmHg e diastólica > 90 mmHg.

Neste conjunto de dados, a idade média dos homens era de 52,1 anos e das mulheres 51,4 anos. Entre os homens, 47,7% eram fumantes e 16.5% ex-fumantes. Entre as mulheres, apenas 0.4% eram fumantes e também 0,4 % ex-fumantes. A maioria da população considerada estava dentro do peso adequado.

Atividades do Data Mining Utilizadas:

Regressão:

A técnica de regressão foi utilizada para identificar os fatores de risco para hipertensão, através de características do paciente, seu histórico, dados sobre o estilo de vida e resultados dos exames físicos. Estes dados correspondem às variáveis independentes, enquanto o status da hipertensão assume o papel da variável dependente. Um dos artefatos técnicos utilizados no algoritmo para determinar a importância das variáveis consideradas, foi a equação “maximum-likelihood ratio”.

Previsão:

Esta técnica foi implementada através de uma árvore de decisão que considera as variáveis definidas pela técnica de regressão como fatores de risco e determina qual é a tendência de um determinado paciente para a hipertensão. Para a árvore de decisão foram utilizados dois algoritmos, CHAID e C5.0, para efeito de comparação. O CHAID apresentou melhor resultado.

Regras de associação:

A técnica de associação foi usada para identificar a ocorrência de relações entre o resultado positivo de hipertensão e as variáveis de risco, como “fumar”, “beber”, etc, na tentativa de descobrir relações entre estes itens.

Resultados:

O resultado da técnica de regressão mostra que variáveis biomédicas são excelentes indicadores da hipertensão, e, dentre estas variáveis destacam-se o índice de massa corpórea, proteína urinária, taxa de glicose e colesterol.

A técnica de previsão que, através da árvore de decisão, define o percentual de probabilidade de o indivíduo adquirir hipertensão, no algoritmo CHAID tem a sensibilidade de 76,3%.

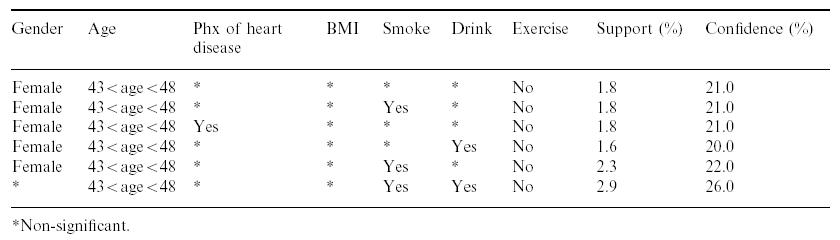

A técnica para descobrimento de regras de associação definiu um grande número de associações entre os fatores de riscos. A figura 6 apresenta uma visão parcial da tabela de regras de associações encontradas com os respectivos índices de suporte e confiança; onde suporte é a probabilidade de i1 e I2 ocorrerem juntos, e confiança é a proporção de ocorrência de i2 considerando todas as ocorrências de i1.

Conclusão:

Os autores concluíram que as técnicas de data mining foram eficientes na descoberta de padrões sobre programas de gerenciamento de hipertensão, mesmo assumindo as limitações do conjunto de dados utilizados no experimento.

Figura 06 – Exemplo de associações descobertas

2.3 – Caso 03: Association Rules and Data Mining in Hospital Infection Control and Public Health Surveillance

Este terceiro artigo (Stephen, 1998), embora não muito recente, apresenta uma perspectiva diferente e interessante sobre a aplicação da técnica data mining para a identificação de regras de associações.

Contexto:

Desenvolvido por pesquisadores da Alabama University em parceria com o Centro para Controle e Prevenção de Doenças dos Estados Unidos (CDC).

O objetivo do trabalho é apresentar um processo de análise de dados capaz de identificar, automaticamente, novos e interessantes padrões nos dados referentes a infecção hospitalar e vigilância sanitária.

Os sistemas de vigilância são essenciais para a detecção de novas ameaças de infecções na saúde pública e nos ambientes hospitalares. A eficácia de um sistema desta natureza é determinada pela sua habilidade de analisar, rapidamente, séries históricas de dados e detectar grupos de doenças não comuns.

O principal problema abordado pelos autores é que a maioria de sistemas e técnicas para análise dos dados assume que o usuário já tem uma situação pré-definida (ex. infecções por Salmonella em uma determinada região) cuja incidência é monitorada no tempo. Isto significa que, mudanças nas características da incidência que não estão sendo monitoradas, não são detectadas. Visando resolver este problema, os autores propõem a utilização de técnicas de Data Mining que não restrinjam a análise apenas aos indicadores definidos pelo usuário, mas que sejam capazes de identificar novos padrões e associações que consigam detectar mudanças na forma de incidência de uma epidemia ou endemia ou qualquer programa de controle sanitário.

Metodologia:

A principal característica do processo de data mining aqui proposto, é a mudança de paradigma. Enquanto nos sistemas tradicionais de vigilância prioriza-se uma alta freqüência e um alto grau de confiança nas regras de associações existentes, a proposta aqui é inversa; as associações com uma alta freqüência e com um baixo nível de confiança são as mais utilizadas. A razão é simples: Se um fenômeno B ocorre toda vez que um fenômeno A ocorre e o fenômeno A ocorre com muita freqüência, provavelmente trata-se de uma situação trivial ou muito bem conhecida. Se, por outro lado, um fenômeno B ocorre em apenas algumas situações que A ocorre, nestas condições a associação A Þ B é uma associação de baixa confiança. Porém, se, ao longo do tempo, o grau de confiança desta associação aumentar, isto pode indicar uma alteração na característica de incidência do problema. Este fato é extremamente importante para atividades de prevenção e, raramente são detectados por ferramentas de análises tradicionais.

O processo geral da solução data mining proposta, é muito simples e constituído basicamente pelas seguintes etapas:

- Os dados que serão analisados são divididos em partes, seguindo uma divisão temporal, e, em cada parte são aplicadas técnicas de data mining para descobrir todas as associações com alta freqüência;

- Para cada regra de associação identificada neste conjunto de dados (que corresponde a um determinado período de tempo), o seu grau de confiança é comparado com o grau de confiança apresentado por esta mesma regra, no conjunto de dados que corresponde ao período anterior;

- Se o grau de confiança de uma regra sofreu um aumento significativo de um período para o outro, esta regra é sinalizada como um evento que merece atenção;

Para validação da aplicação de data mining foram utilizados dados do UAB Hospital (University of Alabama Birmingham). O escopo de análise foi reduzido aos casos de infecções provocadas por Pseudomonas Aeruginosa durante o ano de 1996. Cada registro corresponde a um caso de infecção por Aeruginosa e é constituído, basicamente, pelos atributos: data de ocorrência, localização do paciente no hospital, CEP do paciente e resultado do teste (R = Resistente; I = Intermediário; S = suscetível) para piperacillin, ticarcillin / clavulanate, ceftazidime, imipenem, amikacin, gentamicin, tobramycin, e ciprofloxacin.

Para detecção de novas regras de associação, o experimento foi realizado por três vezes, considerando diferentes divisões dos dados. Em cada divisão foi considerado um período de tempo diferente. Foram considerados períodos de um, três e seis meses, respectivamente, para os experimentos A, B e C.

Para análise das regras de associação foi considerada uma freqüência 10 em todos os experimentos.

Técnicas Data Mining utilizadas:

Associação:

A solução proposta no trabalho, basicamente, consiste na aplicação de técnicas de associação visando a identificação de novas correlações nos dados. Foi utilizado o algoritmo simples chi-square para a definição de regras de associação.

Resultados:

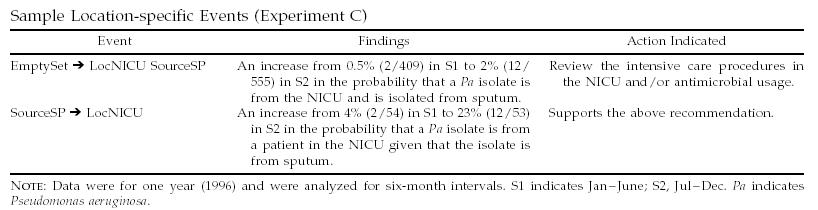

O processo de data mining descobriu e monitorou mais de 2.000 associações no experimento A, mais de 12.000 no experimento B e mais de 20.000 no C. Uma análise dos eventos descobertos mostrou que, a maioria dos eventos descobertos no experimento A não foram detectados no experimento B e, também, não foram encontrados no C. No entanto, alguns eventos interessantes foram detectados e para eles, ações preventivas foram sugeridas, como mostra a figura 7.

Figura 07 – Eventos descobertos e ações sugeridas

Conclusão:

Os autores definiram um novo processo de data mining para identificação e monitoramento de novos padrões e associações nos dados, o qual se mostra eficiente e adequado para sistemas de vigilância sanitária. Os experimentos realizados validaram a eficiência do processo para a identificação de eventos interessantes, mesmo sem conhecimento prévio, podendo, inclusive, gerar ações preventivas.

Bom, o campo de aplicação para as técnicas e ferramentas de data mining é bastante amplo. Em diversos segmentos, para diferentes problemas, as soluções construídas a partir do conceito de mineração de dados, vêm se mostrando eficientes. Na área da saúde, onde qualquer atividade é altamente dependente de informação, a aplicabilidade deste tipo de ferramenta é ideal e, em alguns casos, extremamente necessária.

Os sistemas de saúde de maneira geral, e os sistemas de informação em saúde em particular, têm-se beneficiado das técnicas e instrumentos de mineração de dados já há anos, seja na recuperação de informação eventualmente utilizada em descobertas baseadas em literatura, seja na extração de conhecimento de bases de dados factuais, bibliográficas e de texto completo, como as mantidas em extranets pela industria farmacêutica.

A mineração de dados na própria web ainda é relativamente pouco realizada e, surpreendentemente, tem ocorrido com menor freqüência, Porém é prática comum em vários domínios. [http://www.kdnuggets.com/polls/2005/data_types.htm].

Foram apresentados, neste trabalho, alguns conceitos básicos e exemplos sobre esta tecnologia que propõem soluções a problemas inerentes aos sistemas de saúde, que são importantes e relativamente comuns a praticamente todos os países do mundo.

No primeiro exemplo é apresentado um dos problemas mais sérios da saúde, que em muitos casos provocam verdadeiros colapsos no sistema. Uma solução, baseada em técnicas de data mining é apresentada através de um mecanismo de detecção de fraudes e abusos. Se bem sucedida, a solução proposta representará uma expressiva economia em benefício do sistema de saúde.

O segundo exemplo mostra como uma ferramenta Data Mining capaz de prever a ocorrência de patologias ou simplesmente mostrar a tendência de ocorrência baseada nas características da população, pode aumentar a qualidade preventiva da saúde pública e auxiliar, de maneira substancial, os programas de saúde implantados por governos ou instituições.

O terceiro exemplo reforça, de maneira brilhante, a idéia de como este tipo de solução pode, de fato, contribuir decisivamente nas ações preventivas destinadas à saúde pública. É apresentada uma solução, destinada à vigilância sanitária, que identifica e monitora padrões de comportamento de problemas, como epidemias e endemias, e detecta mudanças nas características destes problemas, permitindo que ações sejam tomadas antes mesmo de um surto da situação.

Os casos apresentados mostram que é possível utilizar soluções construídas a partir de técnicas de data mining para resolver problemas existentes na gestão dos serviços de saúde e conseqüentemente beneficiar a população que recebe estes serviços.

É isso ai pessoal. Espero que tenham aproveitado, até a próxima coluna.

Referências

Berry, J.A, Linoff, Gordon S. Mastering Data Mining. New York: John Wiley & Sons; 2000.

Chae, Young Moon; Ho, Seumg Hee; Cho, Won Kyoung; Lee, Dong Ha; Ji, Sun Ha. Data Mining approach to policy analysis in health insurance domain, International Journal of Medical Informatics, 62 (2001) 103-111.

Goebel, M, Gruenwald, L. A survey of data mining and knowledge discovery software tools. SIGKDD Explorations 1999 Jun; 1: 20-33.

Kolodner, J. Case-Based Reasoning. Florida: Morgan Kaufmann; 1993.

Stephen E. Brossette, Alan P. Sprague, J. Michael Hardin, Ken B. Waites, Warren T. Jones, Stephen A. Moser. Associations Rules and Data Mining in Hospital Infection Control and Public Health Surveillance, Journal of the American Medical Informatics Association, V. 5 N. 4 (1998) 3713-181.

Yang, Wan-Shiou, Wang San-Yih. A process-mining framework for the detection of healthcare fraud and abuse, Expert Systems with Applications 31 (2006) 56–68.

Vander Emiro Muniz

www.triscal.com.br